ChatGPT 的高级语音模式获得重大更新:听起来更自然了

OpenAI 在去年推出 GPT-4o 的同时,还推出了高级语音模式。该功能使用 GPT-4o 等原生多模态模型,可以在 232 毫秒(平均 320 毫秒)内响应音频输入,与人类在典型对话中的响应时间相似。它还能生成感觉更自然的音频,捕捉非语言线索,如你说话的速度,并做出有情感的回应。

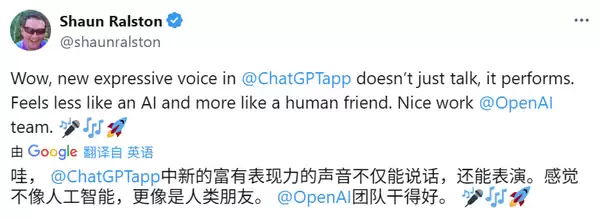

今年年初,OpenAI 发布了 “高级语音模式” 的一个小更新,减少了中断并改善了口音。今天,OpenAI 对 “高级语音模式” 进行了重大升级,使其听起来更自然、更像人。现在,语音应答具有更微妙的语调、逼真的语调(包括停顿和强调),以及对某些情绪(如同情和讽刺)更准确的表达能力。

Windows 11 KB5034218 测试版已发布:提供智能快照布局

本次更新还引入了翻译支持。ChatGPT 用户现在可以使用高级语音模式在不同语言之间进行翻译。只需要求 ChatGPT 开始翻译,它就会在整个对话过程中继续翻译,直到指示停止。这一功能有效地取代了对专用语音翻译应用程序的需求。

目前,更新后的高级语音模式仅适用于 ChatGPT 的付费用户。OpenAI 还指出,这一最新更新存在一些已知的限制,概述如下。

- 此更新有时可能会导致音频质量略有下降,例如音调和音调的意外变化,尤其是某些语音选项。OpenAI 希望随着时间的推移提高音频一致性。

- 语音模式下的罕见幻觉仍然存在,有时会产生类似于广告、胡言乱语或背景音乐的意外声音。

虽然仍然存在一些小限制,但源源不断的改进表明,人类和 AI 对话之间的界限将变得越来越难以区分。

微软修复了 Windows 启动到 BitLocker 恢复的问题

暂无标签

评论功能已关闭